人工智能应用软件开发中的陷阱 从开发到部署的全方位警示

随着人工智能技术浪潮席卷全球,从初创公司到科技巨头,越来越多的企业投身于AI应用软件的开发。这条看似光明的创新之路,实则布满了技术、伦理与商业上的陷阱。深入理解这些陷阱,对于构建可持续、负责任且有价值的AI应用至关重要。

一、 开发阶段的“技术乌托邦”陷阱

- 数据迷信与质量陷阱:许多团队陷入“唯数据论”,认为只要有海量数据就能训练出优秀模型。数据质量、偏见、代表性和标注准确性往往是项目失败的首要原因。使用带有偏见或噪声的数据集,会导致模型在现实世界中表现不佳,甚至放大社会不公。

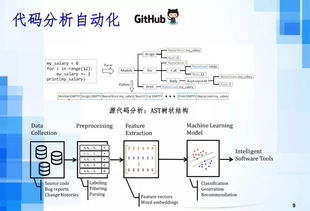

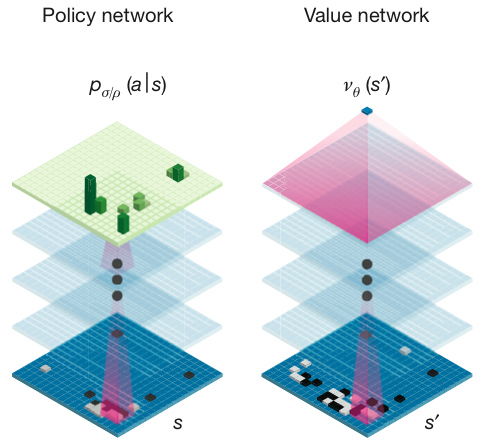

- “黑箱”复杂性与可解释性缺失:为了追求极致的准确率,开发者可能过度依赖深度神经网络等复杂模型,牺牲了模型的可解释性。当模型做出错误或意外的决策时,开发者难以追溯原因,这不仅影响调试和优化,更在医疗、金融等高风险领域埋下隐患。

- 技术选型与“锤子找钉子”:盲目追逐最新、最热的算法框架(如盲目使用大语言模型处理所有任务),而不考虑问题的实际需求、计算成本与维护难度,常导致项目过度工程化,性价比极低。

二、 部署与集成阶段的“现实落差”陷阱

- 环境差异与性能滑坡:在实验室或标准测试集上表现优异的模型,一旦部署到真实、动态、数据分布可能漂移的生产环境中,性能往往会出现显著下降。忽略对持续监控和自适应机制的设计,是常见的技术债。

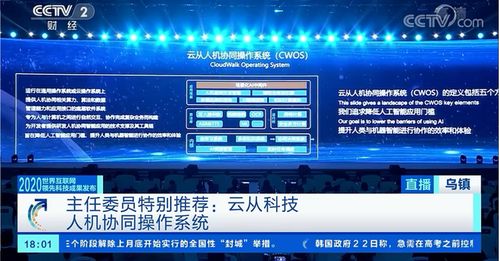

- 系统集成与安全漏洞:AI模块并非孤立存在,需要与现有IT系统、硬件设备和工作流程深度融合。糟糕的API设计、脆弱的数据管道、以及对对抗性攻击的防御不足(如图像识别系统被精心扰动的输入欺骗),都会让整个系统暴露在风险之下。

- 算力成本与可扩展性瓶颈:低估模型推理所需的计算资源和能耗,可能导致应用上线后运营成本失控,无法实现规模化扩展。

三、 使用与伦理层面的“责任盲区”陷阱

- 隐私侵犯与数据滥用:在数据收集、存储和使用过程中,若未能严格遵守“隐私设计”原则和法律法规(如GDPR),不仅会引发用户信任危机,更可能招致严厉的法律制裁。

- 自动化偏见与公平性危机:如果开发过程中缺乏对公平性的审计,模型可能会在招聘、信贷、司法辅助等场景中,系统性歧视某些群体,将历史偏见编码固化,造成新的社会不公。

- 责任界定模糊与过度依赖:当AI辅助决策导致错误时,责任应归于开发者、部署者还是使用者?界定不清会引发伦理和法律纠纷。用户可能对AI产生不切实际的信任,放弃必要的监督和批判性思考,导致“自动化偏见”——盲目接受系统输出。

- 长期社会影响与就业冲击:专注于短期效率提升,而忽视AI应用对工作岗位、工作方式乃至社会结构的长期冲击,是一种战略短视,可能引发广泛的社会矛盾。

四、 规避陷阱的路径与原则

要成功穿越这片“雷区”,开发者与组织需要建立系统性的防御思维:

- 以问题为导向,而非技术炫耀:始终从实际业务需求和待解决的问题出发,选择最合适而非最复杂的技术方案。

- 拥抱“负责任的人工智能”框架:将公平性、可解释性、稳健性、隐私保护和问责制,作为核心设计原则贯穿开发全生命周期。建立多学科的伦理审查委员会。

- 实施全链路数据治理:从源头确保数据质量、代表性和合规性,并建立持续的数据监控与更新机制。

- 采用“人在回路”与渐进部署:在关键决策中保留人类的监督和最终裁决权,并通过小范围试点、A/B测试等方式逐步验证和部署系统。

- 投资于可解释性AI与监控工具:开发或采用工具来理解模型决策依据,并建立完善的性能监控、警报和模型迭代流程。

- 保持法律合规性与社会对话:密切关注全球AI监管动态,确保合规,并主动与公众、政策制定者沟通,管理社会预期。

人工智能应用软件的开发是一场兼具技术深度与社会广度的复杂征程。真正的成功不在于模型参数的多少,而在于能否以清醒的认知、审慎的态度和负责任的原则,驾驭这项强大的技术,最终创造出既智能又可信、既高效又公平的解决方案,真正服务于人。避开陷阱,方能行稳致远。

如若转载,请注明出处:http://www.44956050359.com/product/41.html

更新时间:2026-02-27 05:41:39